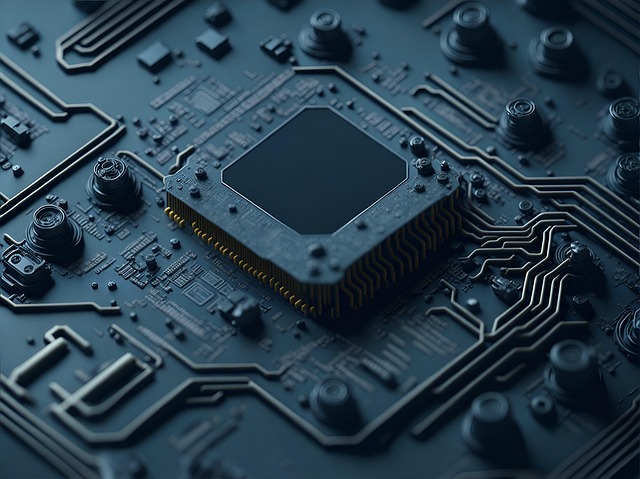

Optymalizacja zasobów GPU dla kompilacji shaderów w robotyce mobilnej – klucz do stabilnej wizji komputerowej

Robotyka mobilna, zwłaszcza w kontekście systemów wizji komputerowej, to dziedzina stawiająca ekstremalne wymagania. Od szybkiego przetwarzania obrazów po precyzyjne planowanie trajektorii, każdy element składowy musi działać niezawodnie i w czasie rzeczywistym. Jednym z często pomijanych, a niezwykle istotnych aspektów jest deterministyczna kompilacja shaderów. Niezrozumienie jej wpływu może prowadzić do irytującego jittera – nagłych, nieprzewidywalnych spadków wydajności, które potrafią zrujnować nawet najlepszy algorytm. Ale jak okiełznać ten potencjalny chaos?

Shader jest małym programem, który działa na karcie graficznej (GPU) i jest odpowiedzialny za generowanie efektów wizualnych. Podczas kompilacji shadera, sterownik karty graficznej tłumaczy kod shadera na instrukcje maszynowe, które GPU rozumie. Ten proces kompilacji może być niedeterministyczny, co oznacza, że za każdym razem, gdy shader jest kompilowany, może wygenerować inny kod maszynowy. To z kolei może prowadzić do różnic w wydajności, a w konsekwencji do jittera w systemie wizji komputerowej robota. Problem jest jeszcze bardziej palący, gdy robot działa w zmiennym środowisku, gdzie każda milisekunda może decydować o powodzeniu misji. Jak zatem zapewnić, by kompilacja shaderów była przewidywalna i stabilna, minimalizując ryzyko nieoczekiwanych skoków wydajności?

Lista kontrolna: kluczowe obszary zarządzania zasobami GPU

Klucz do sukcesu leży w metodycznym podejściu do zarządzania zasobami GPU. Poniżej przedstawiamy listę kontrolną najlepszych praktyk, które pomogą Ci osiągnąć deterministyczną kompilację shaderów i stabilną wydajność systemu wizji komputerowej w robotyce mobilnej. Traktuj to jako mapę drogową, która poprowadzi Cię przez gąszcz potencjalnych problemów.

- Używaj prekompilowanych shaderów: Zamiast kompilować shadery w locie, w czasie działania robota, zdecyduj się na ich prekompilację. Skompiluj wszystkie potrzebne shadery przed wdrożeniem robota i zapisz je w postaci binarnej. Następnie, podczas pracy robota, po prostu wczytaj te binarne shadery. Eliminujesz w ten sposób niedeterministyczny proces kompilacji w czasie rzeczywistym. Pamiętaj jednak, że prekompilacja może wymagać dostosowania do konkretnego modelu GPU, na którym ma działać robot.

- Kontroluj wersję sterowników GPU: Różne wersje sterowników GPU mogą kompilować shadery w różny sposób. Używaj spójnej, przetestowanej wersji sterownika GPU na wszystkich robotach. Co więcej, unikaj automatycznych aktualizacji sterowników, które mogą nieoczekiwanie wprowadzić zmiany w procesie kompilacji shaderów i zakłócić deterministyczność.

- Izoluj proces kompilacji shaderów: Jeśli musisz kompilować shadery dynamicznie, utwórz oddzielny proces (lub wątek) dedykowany wyłącznie do tego zadania. W ten sposób kompilacja shaderów nie będzie konkurować o zasoby GPU z innymi, krytycznymi dla czasu rzeczywistego, zadaniami, takimi jak przetwarzanie obrazów. Ustaw odpowiednie priorytety procesów, aby zadania wizji komputerowej miały pierwszeństwo.

Priorytetyzacja zadań GPU: klucz do płynnej pracy

GPU, podobnie jak procesor, ma skończoną moc obliczeniową. Kiedy wiele zadań próbuje korzystać z GPU w tym samym czasie, dochodzi do konfliktów. Priorytetyzacja zadań GPU jest kluczowa dla zapewnienia płynnej i deterministycznej pracy systemu wizji komputerowej robota. Wyobraź sobie sytuację, w której robot musi jednocześnie analizować obraz z kamery, planować trasę i aktualizować mapę otoczenia. Jeśli wszystkie te zadania mają ten sam priorytet, GPU będzie przełączać się między nimi, co może prowadzić do opóźnień i jittera.

- Używaj kolejek priorytetowych: Większość bibliotek graficznych (np. Vulkan, OpenGL) oferuje mechanizmy kolejek priorytetowych. Wykorzystaj je do nadawania różnym zadaniom GPU różnych priorytetów. Zadania związane z przetwarzaniem obrazów w czasie rzeczywistym powinny mieć najwyższy priorytet, a zadania o mniejszym znaczeniu (np. rendering interfejsu użytkownika) – niższy.

- Ograniczaj równoległość: Zbyt duża liczba równoległych zadań GPU może prowadzić do problemów z wydajnością i determinizmem. Ogranicz liczbę jednoczesnych zadań GPU, aby uniknąć przeciążenia karty graficznej. Możesz to zrobić, np. poprzez użycie semaforów lub mutexów.

- Monitoruj obciążenie GPU: Regularnie monitoruj obciążenie GPU, aby zidentyfikować potencjalne wąskie gardła. Użyj narzędzi do profilowania GPU, aby sprawdzić, które zadania najbardziej obciążają kartę graficzną. Na podstawie zebranych danych, możesz dostosować priorytety zadań i zoptymalizować kod shaderów.

Optymalizacja transferu danych: mniej znaczy więcej

Transfer danych między procesorem a GPU to kolejna potencjalna przyczyna opóźnień i jittera. Przesyłanie dużych ilości danych może zająć dużo czasu i obciążyć magistralę systemową. Dlatego kluczowe jest minimalizowanie ilości danych przesyłanych między procesorem a GPU oraz optymalizacja sposobu ich przesyłania. Pomyśl o tym jak o dostarczaniu przesyłki kurierskiej: lepiej wysłać mniej paczek, ale szybciej i sprawniej.

- Używaj buforów GPU: Zamiast przesyłać dane do GPU za każdym razem, gdy są potrzebne, przechowuj je w buforach GPU. Bufor GPU to obszar pamięci na karcie graficznej, który może być szybko dostępny przez shadery. Przesyłaj dane do bufora GPU tylko raz, a następnie używaj ich wielokrotnie.

- Minimalizuj kopie danych: Unikaj niepotrzebnych kopii danych między różnymi buforami GPU. Kopiowanie danych zajmuje czas i zużywa zasoby GPU. Jeśli to możliwe, używaj buforów współdzielonych, które mogą być bezpośrednio dostępne przez różne shadery.

- Używaj asynchronicznych transferów danych: Używaj asynchronicznych transferów danych, aby przesyłać dane do GPU w tle, podczas gdy procesor wykonuje inne zadania. Asynchroniczne transfery danych pozwalają uniknąć blokowania procesora i poprawiają ogólną wydajność systemu.

- Korzystaj z technik kompresji: W przypadku bardzo dużych tekstur lub danych geometrycznych, rozważ użycie technik kompresji, aby zmniejszyć ilość danych przesyłanych do GPU. Istnieją różne algorytmy kompresji, które mogą być używane do kompresji tekstur i danych geometrycznych. Wybierz algorytm, który jest odpowiedni dla twojego przypadku użycia.

Zarządzanie pamięcią GPU: unikanie przeciążeń i wycieków

Pamięć GPU jest ograniczona. Nieprawidłowe zarządzanie pamięcią GPU może prowadzić do przeciążeń, wycieków pamięci i awarii systemu. Dlatego ważne jest, aby starannie planować wykorzystanie pamięci GPU i zwalniać zasoby, gdy nie są już potrzebne. Wyobraź sobie, że masz małą spiżarnię: musisz ją mądrze zapełnić, żeby starczyło na wszystko i żeby nic się nie zmarnowało.

- Alokuj pamięć tylko wtedy, gdy jest potrzebna: Nie alokuj pamięci GPU z góry dla wszystkich potencjalnych zasobów. Alokuj pamięć tylko wtedy, gdy jest ona rzeczywiście potrzebna, i zwalniaj ją, gdy nie jest już używana.

- Używaj pul pamięci: Zamiast alokować i zwalniać pamięć GPU pojedynczo, używaj pul pamięci. Pula pamięci to obszar pamięci GPU, który jest podzielony na mniejsze bloki. Alokacja i zwalnianie bloków pamięci z puli jest znacznie szybsze niż alokacja i zwalnianie pojedynczych obiektów.

- Unikaj wycieków pamięci: Upewnij się, że zwalniasz wszystkie zasoby GPU, gdy nie są już potrzebne. Wycieki pamięci mogą prowadzić do stopniowego obniżania wydajności systemu i ostatecznie do awarii. Używaj narzędzi do debugowania pamięci, aby wykrywać i usuwać wycieki pamięci.

- Monitoruj wykorzystanie pamięci GPU: Regularnie monitoruj wykorzystanie pamięci GPU, aby zidentyfikować potencjalne problemy. Jeśli wykorzystanie pamięci GPU jest zbyt wysokie, rozważ zmniejszenie rozmiaru tekstur, uproszczenie modeli geometrycznych lub zoptymalizowanie kodu shaderów.

Profilowanie i debugowanie: znajdź słabe punkty

Nawet najlepsze praktyki mogą okazać się niewystarczające, jeśli nie potrafisz zidentyfikować i rozwiązać konkretnych problemów w swoim systemie. Profilowanie i debugowanie są niezbędne do optymalizacji wydajności i determinizmu kompilacji shaderów. Używaj narzędzi do profilowania GPU, aby zidentyfikować wąskie gardła w swoim kodzie. Używaj narzędzi do debugowania shaderów, aby analizować działanie shaderów i wykrywać potencjalne problemy. To trochę jak wizyta u lekarza – regularne badania pozwalają wykryć problemy na wczesnym etapie i uniknąć poważnych konsekwencji.

- Używaj narzędzi do profilowania GPU: Istnieje wiele narzędzi do profilowania GPU, które mogą pomóc Ci zidentyfikować wąskie gardła w swoim kodzie. Narzędzia te pokazują, które zadania GPU zajmują najwięcej czasu i zużywają najwięcej zasobów. Na podstawie tych informacji, możesz zoptymalizować swój kod i poprawić wydajność systemu.

- Używaj narzędzi do debugowania shaderów: Narzędzia do debugowania shaderów pozwalają analizować działanie shaderów i wykrywać potencjalne problemy. Możesz użyć tych narzędzi, aby sprawdzić, czy shadery działają poprawnie i czy nie powodują błędów.

- Automatyzuj testy: Stwórz zautomatyzowane testy, które będą regularnie sprawdzać wydajność i determinizm kompilacji shaderów. Testy te powinny obejmować różne scenariusze i warunki obciążenia. Automatyzacja testów pozwala szybko wykryć problemy i uniknąć ich wprowadzenia do produkcyjnego kodu.

- Testuj na docelowym sprzęcie: Upewnij się, że testujesz swój kod na docelowym sprzęcie, na którym będzie działał robot. Różne modele GPU mogą mieć różne charakterystyki wydajnościowe. Testowanie na docelowym sprzęcie pozwala uniknąć niespodzianek podczas wdrożenia.

Implementacja tych praktyk to inwestycja, która szybko się zwraca. Stabilna i deterministyczna kompilacja shaderów przekłada się na płynną pracę systemu wizji komputerowej, a to z kolei bezpośrednio wpływa na niezawodność i efektywność robota mobilnego. Unikniesz frustrujących, nagłych spadków wydajności i będziesz mógł skupić się na rozwoju bardziej zaawansowanych algorytmów i funkcjonalności.