Jitter w Wizji Komputerowej Robotów Mobilnych: Źródła i Metody Pomiaru

W świecie robotyki mobilnej, gdzie każda milisekunda i każdy piksel mają znaczenie, minimalizacja opóźnień i zapewnienie stabilności działania systemów wizyjnych staje się kluczowe. Wyobraźmy sobie autonomicznego robota dostarczającego paczki, który na podstawie obrazu z kamery musi podjąć decyzję o ominięciu przeszkody. Jeśli obraz jest przetwarzany z nieprzewidywalnymi opóźnieniami, czyli wykazuje jitter, robot może zareagować zbyt późno, powodując kolizję. Zrozumienie i minimalizacja jittera w systemach wizji komputerowej robotów mobilnych to absolutna konieczność dla ich sprawnego i bezpiecznego funkcjonowania.

Źródła Jittera w Systemach Wizyjnych Robotów Mobilnych

Jitter, definiowany jako niepożądane i nieprzewidywalne wahania opóźnień w systemie, ma wiele źródeł w kontekście wizji komputerowej robotów mobilnych. Jednym z głównych winowajców jest niedeterminizm oprogramowania. Operacje na wysokim poziomie, takie jak alokacja pamięci, działanie garbage collectora czy przełączanie wątków przez system operacyjny, wprowadzają losowe opóźnienia, trudne do przewidzenia i kontrolowania. Programowanie w językach takich jak Python, które charakteryzują się elastycznością i łatwością użycia, często wiąże się z ukrytymi kosztami w postaci niedeterministycznych operacji, które mogą powodować jitter.

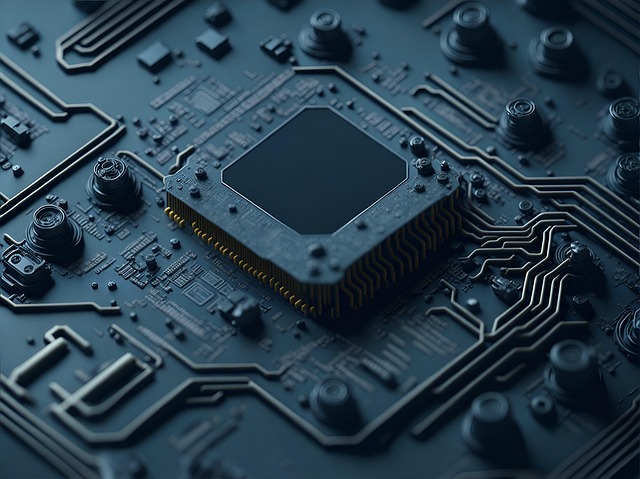

Kolejnym istotnym źródłem jittera jest przetwarzanie obrazu na GPU, a w szczególności proces kompilacji shaderów. Shaders, programy wykonywane bezpośrednio na procesorze graficznym, odpowiedzialne za transformacje geometryczne i efekty wizualne, są często kompilowane w locie, czyli w momencie ich pierwszego użycia. Ten proces kompilacji może trwać różny czas w zależności od wielu czynników, takich jak model GPU, sterowniki, a nawet aktualne obciążenie systemu. Efekt? Nieprzewidywalne opóźnienia w przetwarzaniu obrazu. Wyobraźmy sobie robota wyposażonego w system rozpoznawania obiektów oparty na głębokich sieciach neuronowych. Jeśli kompilacja shaderów odpowiadających za warstwy konwolucyjne sieci trwa zbyt długo, robot może stracić orientację w otoczeniu lub nie zareagować na czas na pojawiające się przeszkody. Ponadto, różnice w architekturach i sterownikach GPU różnych producentów oznaczają, że ten sam kod może wykazywać różny jitter na różnych platformach sprzętowych.

Komunikacja między komponentami systemu również generuje jitter. Przesyłanie danych z kamery do jednostki centralnej robota (CPU), a następnie do GPU, odbywa się za pośrednictwem magistral danych, takich jak USB, Ethernet czy PCI Express. Opóźnienia w transmisji danych, spowodowane przeciążeniem magistrali, zakłóceniami elektromagnetycznymi lub nieefektywnymi protokołami komunikacyjnymi, przyczyniają się do ogólnego jittera systemu. Na przykład, jeśli kamera przesyła strumień wideo wysokiej rozdzielczości przez sieć Wi-Fi, zmienne warunki sieciowe mogą powodować losowe opóźnienia w dostarczaniu ramek do systemu przetwarzania obrazu.

Wreszcie, czynniki środowiskowe, takie jak temperatura i wibracje, mogą wpływać na stabilność działania komponentów elektronicznych, w tym kamer i procesorów, co pośrednio przyczynia się do jittera. Zmiany temperatury mogą wpływać na charakterystyki elektryczne układów, a wibracje mogą powodować mikropęknięcia w połączeniach, prowadząc do sporadycznych błędów i opóźnień. Te czynniki są szczególnie istotne w robotach działających w trudnych warunkach środowiskowych, na przykład w magazynach lub fabrykach.

Metody Pomiaru Jittera w Systemach Wizyjnych

Skuteczna minimalizacja jittera wymaga precyzyjnego pomiaru i kwantyfikacji jego wartości. Istnieje kilka metod pozwalających na ocenę jittera w systemach wizyjnych robotów mobilnych. Jedną z najprostszych jest pomiar opóźnienia między momentem przechwycenia obrazu przez kamerę a momentem jego przetworzenia. Można to zrealizować poprzez synchronizację czasu między kamerą a jednostką centralną robota i rejestrowanie znaczników czasowych na każdym etapie przetwarzania obrazu. Różnica między znacznikami czasowymi reprezentuje całkowite opóźnienie, a wahania tego opóźnienia definiują jitter. Ważne jest, aby pomiary były wykonywane w warunkach zbliżonych do rzeczywistych warunków pracy robota, uwzględniając obciążenie systemu i czynniki środowiskowe.

Inną metodą jest analiza strumienia wideo. Polega ona na umieszczeniu w polu widzenia kamery obiektu o znanym ruchu i śledzeniu jego położenia w kolejnych klatkach wideo. Jitter objawia się jako nieoczekiwane i nagłe zmiany w pozycji obiektu, niezgodne z jego przewidywalnym ruchem. Analiza wariancji położenia obiektu pozwala na kwantyfikację jittera. Ta metoda jest szczególnie przydatna do oceny wpływu jittera na dokładność śledzenia obiektów i nawigacji robota.

Użycie specjalistycznych narzędzi do profilowania i debugowania może również pomóc w identyfikacji źródeł jittera. Narzędzia te pozwalają na monitorowanie wykorzystania zasobów systemowych, takich jak procesor, pamięć i GPU, oraz na analizę czasu wykonywania poszczególnych fragmentów kodu. Identyfikacja wąskich gardeł i operacji powodujących opóźnienia jest kluczowa do optymalizacji systemu i minimalizacji jittera. Na przykład, profilowanie kodu shaderów może ujawnić, które operacje są najbardziej kosztowne i gdzie należy szukać możliwości optymalizacji.

Kwantyfikacja Jittera: Metryki i Interpretacja

Po zebraniu danych pomiarowych konieczne jest kwantyfikowanie jittera za pomocą odpowiednich metryk. Najczęściej używaną metryką jest wariancja opóźnienia, która mierzy rozproszenie wartości opóźnienia wokół wartości średniej. Wysoka wariancja wskazuje na duży jitter, natomiast niska wariancja sugeruje stabilne opóźnienia. Inną przydatną metryką jest maksymalna wartość jittera, która reprezentuje największą różnicę między wartością opóźnienia a wartością średnią. Ta metryka jest szczególnie istotna w systemach czasu rzeczywistego, gdzie duże, sporadyczne opóźnienia mogą prowadzić do poważnych problemów.

Interpretacja wartości jittera zależy od konkretnego zastosowania robota. W systemach, gdzie precyzja i czas reakcji są krytyczne, nawet niewielki jitter może być niedopuszczalny. Na przykład, w robotach chirurgicznych jitter w wizji komputerowej może prowadzić do błędów w precyzyjnych operacjach. Z drugiej strony, w robotach wykonujących mniej krytyczne zadania, takich jak sprzątanie, większy jitter może być akceptowalny, o ile nie wpływa negatywnie na ogólną wydajność robota. Kluczowe jest określenie akceptowalnego poziomu jittera na podstawie analizy ryzyka i wymagań konkretnego zastosowania.

Oprócz statystycznych metryk, warto również wizualizować jitter za pomocą histogramów i wykresów czasowych. Histogram opóźnień pozwala na ocenę rozkładu wartości opóźnienia i identyfikację potencjalnych źródeł jittera. Wykres czasowy opóźnień pokazuje, jak opóźnienie zmienia się w czasie, co pozwala na identyfikację wzorców i korelacji z innymi zmiennymi systemowymi.

Minimalizacja Jittera: Strategie i Techniki

Minimalizacja jittera w systemach wizyjnych robotów mobilnych to złożony proces, który wymaga holistycznego podejścia, obejmującego optymalizację oprogramowania, sprzętu i architektury systemu. Jednym z kluczowych kroków jest użycie deterministycznych języków programowania i bibliotek. Języki takie jak C++ z odpowiednimi bibliotekami czasu rzeczywistego pozwalają na precyzyjną kontrolę nad alokacją pamięci i zarządzaniem wątkami, minimalizując ryzyko niedeterministycznych operacji. Unikanie garbage collectora i ręczne zarządzanie pamięcią może również przyczynić się do redukcji jittera.

W kontekście przetwarzania obrazu na GPU, kompilacja shaderów offline jest skuteczną techniką minimalizacji jittera. Polega ona na kompilacji shaderów przed uruchomieniem systemu, eliminując opóźnienia związane z kompilacją w locie. Skompilowane shadery mogą być następnie zapisywane w plikach i wczytywane podczas uruchamiania systemu, zapewniając deterministyczny czas ich uruchomienia. Wymaga to jednak wcześniejszego poznania wszystkich shaderów, które będą używane przez system. Wybór odpowiedniego API graficznego również ma znaczenie. API takie jak Vulkan, dają większą kontrolę nad procesem kompilacji shaderów niż np. OpenGL.

Optymalizacja komunikacji między komponentami systemu jest kolejnym ważnym krokiem. Wybór odpowiedniej magistrali danych i protokołu komunikacyjnego może znacząco wpłynąć na opóźnienia w transmisji danych. Użycie magistrali o dużej przepustowości i protokołów o niskim narzucie może zmniejszyć jitter spowodowany komunikacją. Dodatkowo, implementacja mechanizmów buforowania i synchronizacji danych może pomóc w wygładzeniu wahań opóźnień.

Wreszcie, dobór odpowiedniego sprzętu jest kluczowy. Wybór kamery o niskim opóźnieniu, wydajnego procesora i GPU oraz szybkiej pamięci może znacząco poprawić stabilność i wydajność systemu wizyjnego. Ważne jest również uwzględnienie czynników środowiskowych, takich jak temperatura i wibracje, i dobranie komponentów odpornych na te czynniki. Inwestycja w wysokiej jakości komponenty może przełożyć się na znaczną redukcję jittera i poprawę niezawodności robota.

Konkluzja

Jitter w wizji komputerowej robotów mobilnych stanowi poważne wyzwanie, wpływające na ich wydajność i niezawodność. Zrozumienie źródeł jittera i stosowanie odpowiednich metod pomiaru i minimalizacji jest kluczowe dla budowy sprawnych i bezpiecznych robotów. Od deterministycznego programowania po optymalizację sprzętu, istnieje wiele technik, które można zastosować, aby zredukować jitter i poprawić jakość wizji komputerowej. Minimalizacja jittera to nie tylko kwestia techniczna, ale również strategiczna, wpływająca na konkurencyjność i innowacyjność robotyki mobilnej. Inwestycja w deterministyczne kompilatory shaderów, jak podkreśla główny temat, jest tutaj tylko jednym, choć istotnym, elementem układanki.